とりあえず画像生成ができるまで短く簡潔に解説します。

Stable Diffusion web UIのバージョン:v1.6.0-2-g4afaaf8a

GPU:Geforce rtx 3060

モデルのダウンロード

Hugging FaceやCivitaiなどからモデルをダウンロードします。

今回はStable Diffusion XL(SDXL)をHugging Faceからダウンロードする例とします。

以下のURLから「sd_xl_base_1.0.safetensors」をダウンロードします。

stabilityai/stable-diffusion-xl-base-1.0 at main

We’re on a journey to advance and democratize artificial intelligence through open source and open science.

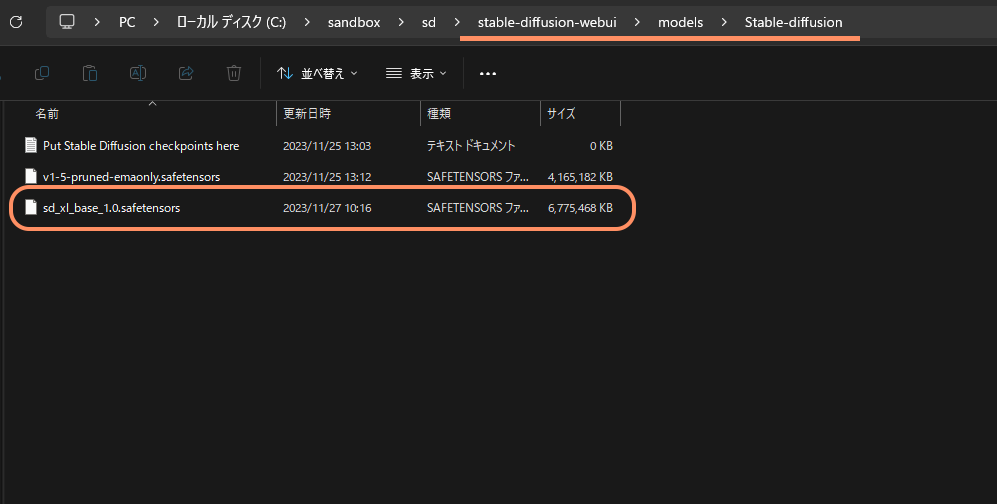

Stable Diffusion web UIに追加する

先程ダウンロードした「sd_xl_base_1.0.safetensors」を

「stable-diffusion-webui」 > 「models」 > 「Stable-diffusion」内に移動させます。

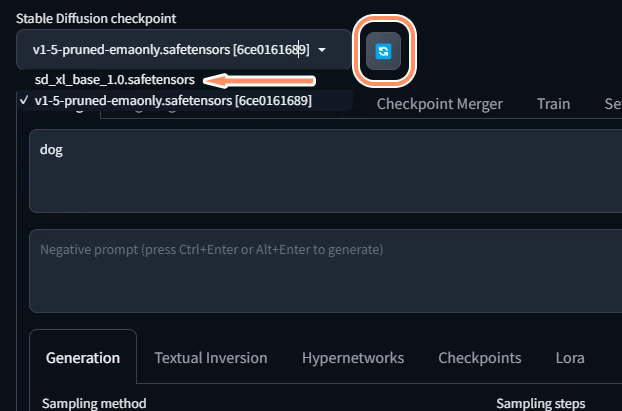

Stable diffusion web UIを反映させる

既に起動している状態であればStable Diffusion checkpointの右にある更新ボタンを押します。

すると、「sd_xl_base_1.0.safetensors」が出てくるので選択します。

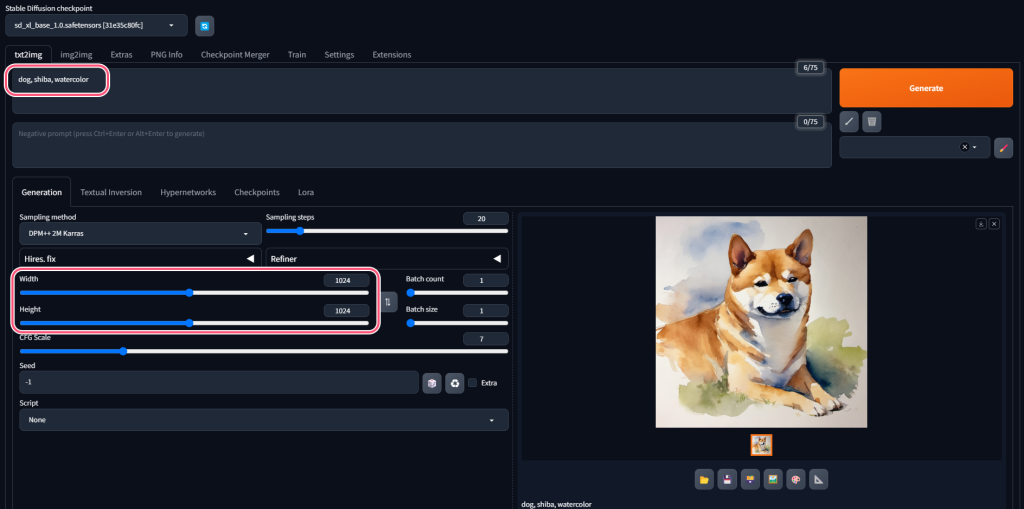

動作確認

プロンプトに「dog, shiba, watercolor」を入力します。

WidthとHeightを1024pxに変更します。(画像サイズは使用するモデルによって異なります。生成される画像の完成度を左右する重要な設定です。)

そしてGenerateボタンをクリックするとクオリティの高い「柴犬の水彩画」が生成できました!

まとめ

以上がStable diffusion web UIにモデルを追加する方法です。

その他、RefinerモデルやVAEなどを使うと品質を高めることができるのですが、必要になったら追加する形が挫折しづらく、効果を実感できるので良いと思います。

コメント